L’A/B testing est la façon la plus commune, simple, et efficace d’améliorer durablement les performances de vos campagnes marketing

De très nombreux marketeurs peuvent pourtant tirer des conclusions peu claires, engendrant des décisions érronées qui peuvent générer l’effet inverse à celui recherché, à savoir diminuer les performances des campagnes sur la durée.

En suivant ces 4 règles simples, n’importe quel marketeur doit pouvoir planifier, mettre en place et valider avec succès ses A/B testing.

1. Des hypothèses claires

Avant de démarrer tout A/B test, il est essentiel de définir des hypothèses de départ claires et logiques, vous permettant de savoir à l’avance quels seront les KPIs à suivre en fonction des éléments que vous souhaitez tester (copywriting, landing page…). Certains KPIs n’auront en effet aucune raison de changer

Par exemple, si vous testez une nouvelle landing page, tout metric avant la visite – comme le CTR% – n’a aucune raison de changer et il ne faudra pas en tenir compte dans votre analyse. Si vous testez une nouvelle approche rédactionnelle sur une créa native ads, le CTR% sera en général le principal metric à suivre, mais tout KPIs plus en aval dans le funnel de conversion pourra aussi être impacté et devra parfois être pris en compte.

Example d’hypothèses

- Test de Landing page : “augmenter le taux de conversion”

- Test de Creative display : “Augmenter le CTR% tout en maintenant un taux de conversion similaire » ou “Augmenter le taux de conversion, sans trop impacter le CTR%” (dans le cas où vous testez un message beaucoup plus descriptif).

2. Visez de grosses variations

Le volume de vos échantillons test est très important pour valider la fiabilité des résultats de n’importe quel A/B test. Plus la variation sera petite, plus vous aurez besoin de volume, de temps et de budget avant d’arriver à des conclusions. Il est donc essentiel d’arriver le plus rapidement possible à des résultats fiables.

« Be bold ». Ne cherchez pas à tester des modifications mineures et visez un objectif d’au moins +20% de progression. Plus la variation – à la hausse ou à la baisse – sera élevée, moins vous aurez besoin de volume et plus la conclusion sera rapide et fiable.

En plus des simples résultats statistiques, des différences importantes vous permettront de bien mieux comprendre la logique et améliorer votre expertise pour de tests futurs.

Dans le cas où les différences de performances sont faibles, malgré des volumes importants, ne perdez pas de temps et passez à la suite, votre test n’a pas d’effet et c’est déjà une conclusion très claire.

3. Tester peu de choses à la fois

Une erreur fréquente est de tester trop de chose à la fois. En plus de diviser le volume de chaque échantillon, il est fréquent de se perdre dans l’analyse des résultats et ne pas arriver à des conclusions claires.

Si vous souhaitez tester 3 landing pages, 4 Images et 5 wordings différents, vous ne devrez pas tout faire en même temps avec toutes les combinaisons possibles. Tester 2 éléments en même temps sur un seul segment n’est pas une bonne pratique. En effet, peu importe le résultat final, vous ne pourrez pas comprendre si la différence est provoquée par la nouveau wording ou la nouvelle image. La bonne méthodologie serait de tester ces 2 modifications de façon séparée, en parallèle, avec 3 segments ou plus.

Mettre en place de très nombreux tests est possible – et recommandé – mais cela doit être fait de façon successive dans le temps, en suivant un planning d’A/B testing clair qui permettra d’améliorer étape par étape vos résultats.

4. Soyez sûr des résultats

Valider les résultats de chaque A/B test avec un niveau de confiance maximum est l’aspect le plus important. Prendre une ou plusieurs mauvaises décisions à cause d’une d’un résultat non significatif et mal interprété peut générer de grosses baisses de performance sur le long terme.

Assurez-vous d’utiliser des segments parfaitement aléatoires

La première chose à vérifier lorsque vous lancez un A/B test correspond aux segments utilisés, qui doivent être parfaitement aléatoires en terme d’audience et de diffusion dans le temps.

La plupart des plateformes publicitaires modernes proposent des fonctionnalités d’A/B testing, mais vérifiez bien que la diffusion s’effectue sur des audiences identiques, et consultez vos rapports à partir du jour où vous avez commencé votre test (ou celui d’après si vous n’avez pas de filtres horaires).

Grâce à vos hypothèses initiales, vous serez en mesure de détecter immédiatement une anomalie, comme un CTR% différents alors que vous effectuer un test de landing page.

Validez la « significance » statistique

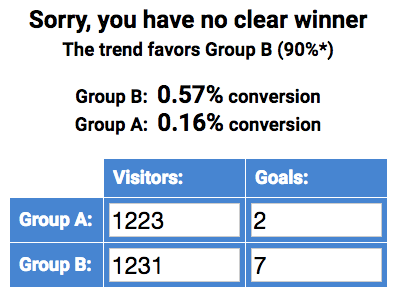

Il s’agit de l’erreur la plus fréquente des marketeurs inexpériementés : tirer des conclusions trop rapides sur des A/B tests avec un volume de data insuffisant.

Alors qu’il est en général très facile d’atteindre des volumes significatifs pour des tests de CTR%, il peut être compliqué d’avoir assez des statistiques fiables lorsqu’il s’agit de tests portant sur les taux de conversion. Par exemple, même avec plus de 2.000 clics sur un test, si seulement 9 Leads ont été générés au total, il n’est pas possible de tirer des conclusions, à moins que les premières tendances soient parfaitement en ligne avec vos prédictions.

Pour être certains de vos résultats, soyez rationnel et utilisez une outil de mesure de la « significance » statistique : http://drpete.co/split-test-calculator

Avec l’experience, vous pourrez vous en passer lorsque les résultats rejoignent vos hypothèses, que les différences de performances sont importantes et que vous atteignez environ 150 clics ou 50 conversions par échantillon.

Challengez les résultats

Si les résultats sont très différents de ce que vous attendiez lors que vos hypothèses, prenez le temps de vérifier de nouveau que les conditions de l’A/B soient bonnes, et n’hésitez pas à renouveler le même test en cas de doute.

Summary

- Commencez avec une Créative « control »

- Définissez vos hypothèses et la logique avant la mise en place d’un A/B test

- Prenez en compte l’ensemble du funnel utilisateur

- Visez gros. Ne testez pas de petites modifications.

- Assurez-vous que votre test soit bien délivré sur des segments aléatoire et sur la même période.

- Validez statistiquement les résultats. Ne prenez pas de conclusions hatives.

- Ne testez pas tout à la fois. Plannifiez étape par étape et tirer les conclusions et apprentissages successifs.

- Comprenez, apprenez et soyez sûrs de vos différentes conclusions.

Reach us at Powerspace for help on setting up your A/B tests.

![[Replay] Le Native advertising est-t-il en train de remplacer tous les autres formats publicitaires ?](https://powerspace.com/wp-content/uploads/2021/04/le-native-est-il-en-train-de-remplacer-tous-les-formats-pubs-400x250.png)